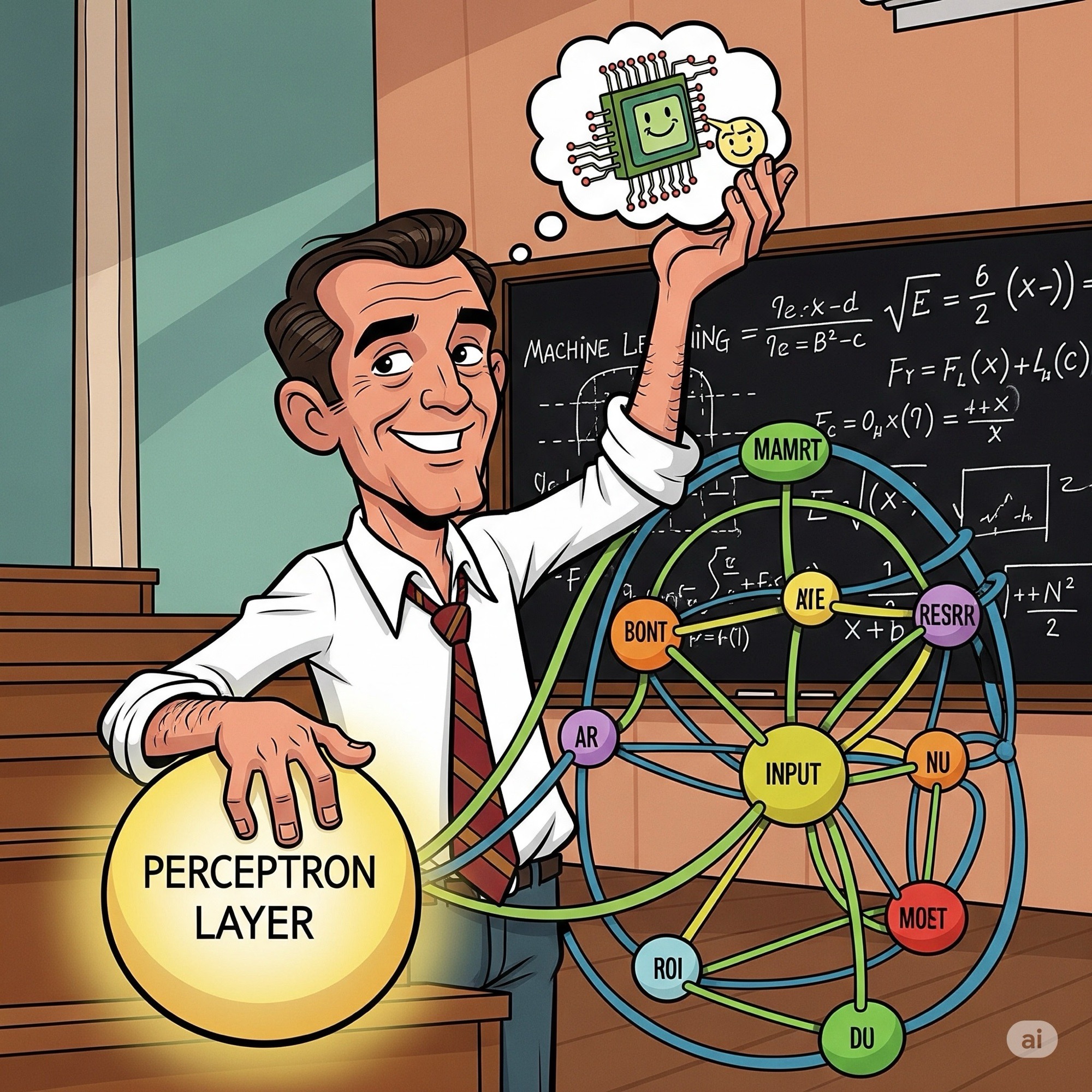

Een perceptron is de fundamentele bouwsteen van een neuraal netwerk. Het is het eenvoudigste type kunstmatig neuraal netwerk, ontworpen om binaire classificatietaken uit te voeren. 🧠 Het werd in 1957 door Frank Rosenblatt geïntroduceerd.

Een perceptron simuleert de werking van een biologisch neuron. Het werkt als volgt:

- Inputs en Gewichten: Het perceptron ontvangt meerdere inputs (numerieke waarden). Elke input heeft een bijbehorend gewicht dat de belangrijkheid ervan bepaalt.

- Gewogen Som: De perceptron berekent de gewogen som van de inputs door elke input te vermenigvuldigen met zijn gewicht en deze bij elkaar op te tellen. Een extra bias term wordt aan deze som toegevoegd.

- Activatie Functie: De gewogen som wordt door een zogenaamde activatie- of stapfunctie gestuurd. Deze functie bepaalt of het perceptron “vuurt” of niet. Als de som een bepaalde drempelwaarde overschrijdt, geeft het een binaire output (bijvoorbeeld 1); anders geeft het de andere binaire output (bijvoorbeeld 0).

- Historisch gezien heeft de perceptron een belangrijke rol gespeeld in de ontwikkeling van machine learning, maar het heeft een significante beperking: het kan alleen data classificeren die lineair scheidbaar is. Dit betekent dat de data in twee groepen kan worden verdeeld door een rechte lijn (of een hypervlak in hogere dimensies). Deze beperking werd in 1969 aangetoond, wat leidde tot een periode van verminderde interesse in AI, bekend als de “AI-winter”.

Tegenwoordig zijn er geavanceerdere neurale netwerken, de zogeheten meerlaagse perceptrons (of Multi-Layer Perceptrons – MLP’s), die deze beperking omzeilen door extra verborgen lagen met neuronen toe te voegen. Deze netwerken kunnen complexe, niet-lineaire relaties in data leren.

The Perceptron Explained legt op een visuele manier uit hoe een perceptron werkt en wat de rol ervan is als de basis van moderne neurale netwerken.