Hoe AI Rekent

Achter de indrukwekkende antwoorden van tools zoals ChatGPT en Gemini schuilt geen magie, maar pure wiskunde. Voor een computer is taal niets anders dan een complexe reeks getallen. In dit artikel duiken we in de belangrijkste numerieke bouwstenen die moderne AI-systemen mogelijk maken.

1. Parameters: De Schaal van Kennis

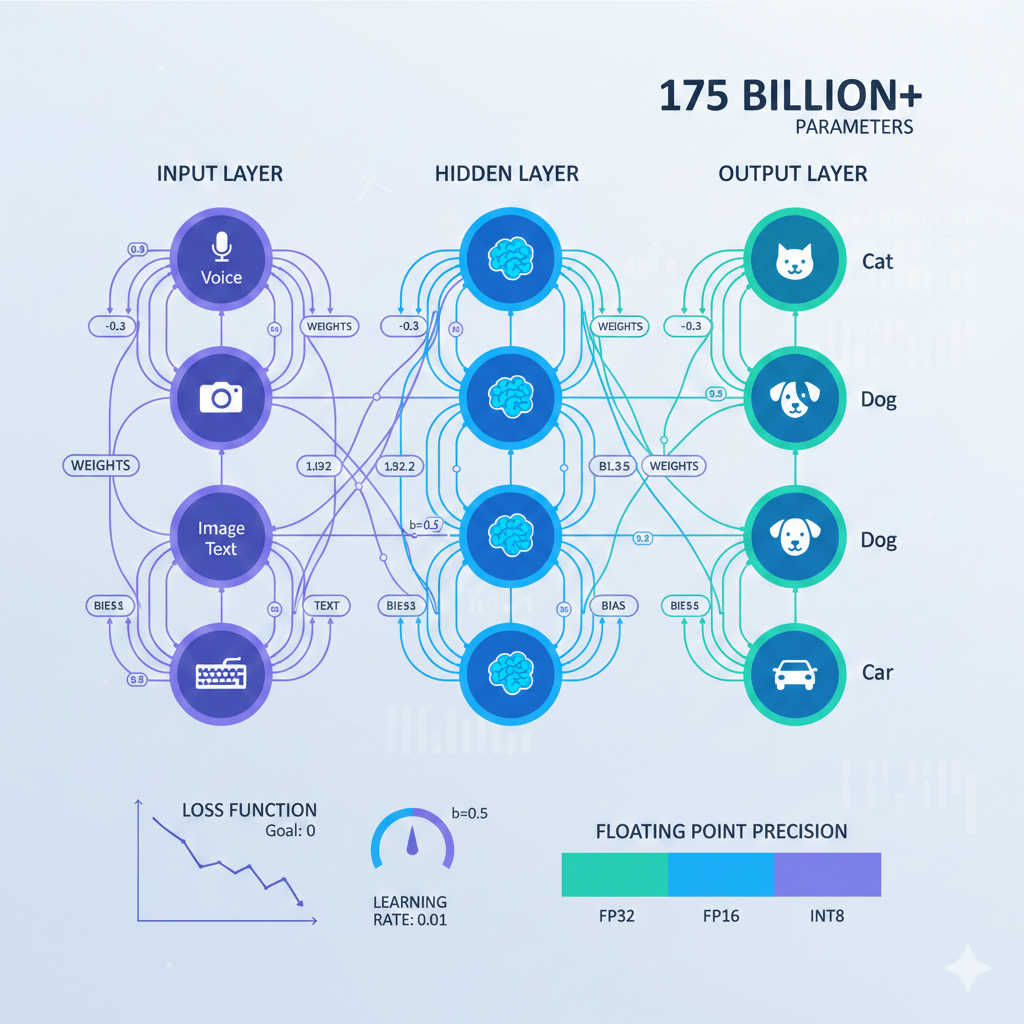

Parameters zijn de interne variabelen die een AI-model leert tijdens het trainingsproces. Je kunt ze zien als de “synapsen” in een digitaal brein. Hoe meer parameters een model heeft, hoe complexer de patronen zijn die het kan herkennen.

Feitelijke gegevens van bekende modellen:

AI-ModelAantal ParametersJaarBron GPT-2 1,5 miljard 2019 OpenAI GPT-3 175 miljard 2020 OpenAI Research GPT-4 ~1,76 biljoen (geschat) 2023 Wikipedia

Belangrijk om te weten:

- GPT-3 werd officieel gelanceerd in juni 2020 met precies 175 miljard parameters OpenAI

- Elke parameter in GPT-3 gebruikt 16-bit precisie, waardoor het model 350GB opslagruimte vereist Wikipedia

- GPT-4’s exacte parametertelling is nooit officieel bevestigd door OpenAI, maar experts zoals George Hotz schatten dit op ongeveer 1,76 biljoen parameters verdeeld over 120 lagen Exploding Topics

- Het model werd getraind op ongeveer 45 terabytes aan tekstdata voor GPT-3, en 1 petabyte voor GPT-4 DeepChecks

Belang: De hoeveelheid parameters bepaalt vaak de nuance en de breedte van de kennis van een model. Meer parameters betekent dat het model subtielere patronen kan herkennen en complexere taken kan uitvoeren.

2. Weights en Biases: De Wiskunde van Beslissingen

Binnen een neuraal netwerk worden verbindingen tussen datapunten gewogen. Dit zijn de fundamentele bouwstenen die bepalen hoe informatie door het netwerk stroomt.

Hoe werken weights en biases?

- Weights (Gewichten): Dit getal bepaalt hoe zwaar een specifiek signaal meeweegt. Als een model een afbeelding van een kat analyseert, krijgt de aanwezigheid van “puntige oren” een hoog gewicht.

- Biases: Dit zijn extra getallen die de drempelwaarde bepalen voordat een neuron “vuurt” (activeert). Ze zorgen ervoor dat het netwerk flexibeler kan reageren op input.

Het doel van AI-training is het vinden van de perfecte waarden voor deze honderden miljarden getallen via een proces dat Backpropagation wordt genoemd.

Backpropagation uitgelegd:

Backpropagation is een algoritme dat de gradiënt van de loss function berekent ten opzichte van elk gewicht in het netwerk GeeksforGeeks. Dit proces:

- Berekent de fout tussen de voorspelde output en de werkelijke waarde

- Werkt deze fout terug door het netwerk

- Past de weights en biases aan om de fout te minimaliseren

- Herhaalt dit proces duizenden of miljoenen keren

Volgens IBM is het fundamentele doel van backpropagation “to train a neural network to make better predictions through supervised learning” door te bepalen hoe model weights en biases moeten worden aangepast om de fout te minimaliseren IBM.

3. Vectoren en Embeddings: Taal in Coördinaten

AI begrijpt woorden niet als letters, maar als coördinaten in een gigantische wiskundige ruimte. Dit noemen we embeddings of woordvectoren.

Het klassieke voorbeeld: Koning – Man + Vrouw = Koningin

In een vectorruimte krijgt elk woord een reeks getallen (een vector). Het beroemde voorbeeld is de vergelijking:

vector(Koning) – vector(Man) + vector(Vrouw) ≈ vector(Koningin)

Dit betekent dat de wiskundige afstand tussen “Koning” en “Koningin” vergelijkbaar is met de afstand tussen “Man” en “Vrouw” Stack Overflow Blog.

Praktische toepassing:

- Woorden met vergelijkbare betekenis staan dicht bij elkaar in de vectorruimte

- “Koning” en “Koningin” hebben een hoge similariteit (dichtbij elkaar)

- “Koning” en “Banaan” staan ver uit elkaar

- Dit stelt AI in staat om synoniemen te begrijpen en verbanden te leggen tussen concepten die niet letterlijk in de tekst staan

Volgens MIT Technology Review beschrijft deze wiskundige relatie een genderlineairiteit: het verschil tussen mannelijke en vrouwelijke termen blijft consistent over verschillende concepten MIT Technology Review.

4. Floating Point Precision (Bits): Precisie versus Efficiëntie

Niet alleen de waarde van het getal is van belang, maar ook de hoeveelheid computergeheugen die het getal inneemt. Dit bepaalt de precisie van berekeningen en de snelheid van het model.

Vergelijking van precisieformaten:

Voor een computer is taal niets anders dan een complexe reeks getallen. In dit artikel duiken we in de belangrijkste numerieke bouwstenen die moderne AI-systemen mogelijk maken.

Quantization: Van 32-bit naar 8-bit

Quantization is het proces waarbij een model dat getraind is in hogere precisie (FP32 of FP16) wordt geconverteerd naar lagere precisie (INT8) Medium.

Impact op prestaties:

- Een model dat oorspronkelijk 100GB geheugen vereiste in FP32, kan na quantization naar INT8 draaien op 25GB

- De reksnelheid kan tot 4x sneller worden zonder merkbaar kwaliteitsverlies Database Mart

- Moderne GPU’s zoals NVIDIA’s Ampere-architectuur zijn specifiek geoptimaliseerd voor FP16 en INT8 berekeningen

Praktisch voorbeeld:

Volgens IBM kan FP32 getallen representeren tussen 10⁻³⁸ en 10³⁸, terwijl FP16 dit bereik reduceert tot 10⁻⁵ tot 10⁵. Voor de meeste AI-toepassingen is dit kleinere bereik volledig voldoende en biedt het aanzienlijke prestatievoordelen IBM Quantization.

5. De Loss Function: Het Getal dat naar Nul Moet

Tijdens het trainen krijgt de AI constant een cijfer voor zijn werk: de Loss Score (verliesfunctie). Dit is de meetlat waarmee het model zijn prestaties evalueert.

Hoe werkt de Loss Function?

De logica:

- Hoe lager de Loss Score, hoe beter de voorspelling van de AI

- De AI past zijn interne parameters (weights en biases) constant aan om dit getal zo dicht mogelijk bij nul te krijgen

- Dit proces wordt herhaald tijdens elke trainingsiteratie

Trainingsproces in stappen:

- Voorspelling maken: Het model verwerkt input en genereert output

- Fout berekenen: De loss function vergelijkt de output met de werkelijke waarde

- Gradient berekenen: Via backpropagation wordt bepaald in welke richting de parameters moeten worden aangepast

- Parameters updaten: Weights en biases worden bijgesteld om de loss te verminderen

- Herhalen: Dit proces wordt duizenden keren herhaald totdat de loss niet meer significant daalt

Volgens Google’s Machine Learning Crash Course maakt het backpropagation-algoritme het mogelijk om deze gradients efficiënt te berekenen voor alle parameters in het netwerk, waardoor training van diepe neurale netwerken praktisch haalbaar wordt Google Developers.

Bronnen en Referenties

Om de feiten in dit artikel te verifiëren, kun je de volgende gezaghebbende bronnen raadplegen:

Primaire bronnen:

- OpenAI Research Papers

- Language Models are Few-Shot Learners – GPT-3 officiële publicatie (2020)

- OpenAI licenses GPT-3 technology to Microsoft – Officiële aankondiging (2020)

- Wikipedia – Wetenschappelijke Referenties

- GPT-3 Wikipedia – Technische specificaties en parameterdetails

- GPT-4 Wikipedia – Schattingen en architectuur

- Backpropagation Wikipedia – Wiskundige achtergrond

- Academische en Technische Bronnen

- NVIDIA Developer Blog – GPT-3 analyse (2020)

- MIT Technology Review – Word embeddings uitgelegd (2015)

- Google Machine Learning Crash Course – Neural network training

- IBM Technical Documentation

- What is Backpropagation? – Theoretische onderbouwing

- What is Quantization? – FP32/FP16/INT8 uitgelegd

- What Are Word Embeddings? – Vector representations

- Aanvullende Technische Resources

- Stack Overflow Blog – Text Embeddings – Praktische uitleg (2023)

- GeeksforGeeks – Backpropagation – Algoritme uitgelegd (2025)

- Medium – FP32, FP16, INT8 Precision – Quantization diepgaand (2024)

- Database Mart – Precision Formats – Vergelijking datatypes

- Exploding Topics – GPT Parameters – Actuele parameterdata (2025)

Conclusie

De kracht van moderne AI-systemen zit in de schaal en precisie van miljarden wiskundige berekeningen. Van de 175 miljard parameters in GPT-3 tot de slimme quantization-technieken die modellen op smartphones draaien – alles draait om getallen. Door deze fundamentele concepten te begrijpen, krijgen we inzicht in hoe AI-systemen leren, denken en antwoorden genereren.

Laatste update: Januari 2026